Ollama: Czy to początek końca dominacji AI w chmurze? Lokalne LLM dostępne jak nigdy dotąd.

Czy rzeczywiście jesteśmy świadkami rewolucji w sposobie, w jaki korzystamy ze sztucznej inteligencji i wchodzimy z nią w interakcje? Świat AI jest niezwykle dynamiczny, a ostatnie miesiące przyniosły znaczące zmiany, które mogą zwiastować nowy układ sił.

Zmiana kierunku wiatru w świecie AI

Przez lata krajobraz sztucznej inteligencji był zdominowany przez potężne modele hostowane w chmurze, takie jak Chat GPT, Google Gemini, Perplexity, czy Claude, oferowane przez technologicznych gigantów. Rozwiązania te przyniosły niezaprzeczalne korzyści: dostęp do ogromnej mocy obliczeniowej, skalowalność niemal bez granic oraz szybki dostęp do najnowszych osiągnięć i innowacji.

Wygoda użytkowania gotowych API sprawiła, że zaawansowane modele LLM stały się dostępne dla firm i deweloperów na niespotykaną wcześniej skalę. Jednak ten model ma również swoje wady. Rosnące koszty subskrypcji lub opłat za wykorzystanie API, często naliczane za każdy przetworzony token, mogą stanowić znaczące obciążenie, szczególnie przy intensywnym użytkowaniu.

Nowy kierunek

W odpowiedzi na te wyzwania, na horyzoncie pojawiły się narzędzia takie jak Ollama, które sygnalizują istotną zmianę. Ollama demokratyzuje dostęp do zaawansowanych modeli językowych (LLM), czyniąc je „dostępnymi jak nigdy dotąd” na urządzeniach lokalnych. Ollama umożliwia uruchamianie modeli AI na własnym komputerze, co otwiera zupełnie nowe możliwości, to właśnie ta demokratyzacja i potencjalne przetasowanie sił rynkowych stanowią sedno „zmiany wiatru” w świecie AI. Obniżenie barier wejścia może prowadzić do fali „hiperpersonalizacji” AI, gdzie użytkownicy i mniejsze firmy będą mogły dostosowywać modele do bardzo specyficznych, niszowych zadań, na które wielcy dostawcy chmurowi mogliby nie zwracać uwagi, wykorzystując do tego łatwość eksperymentowania i kontrolę nad danymi oferowaną przez lokalne narzędzia.

Ollama: co to jest i jak działa?

W centrum tej rewolucji znajduje się Ollama – narzędzie, które radykalnie zmienia sposób, w jaki możemy korzystać z dużych modeli językowych. Ale czym dokładnie jest Ollama i na czym polega jej magia?

Ollama to oprogramowanie open-source, które umożliwia łatwe uruchamianie modeli LLM lokalnie na komputerze użytkownika. Upraszcza konfigurację i eliminuje techniczne przeszkody, oferując prosty proces instalacji i obsługi.

Kluczowe zalety Ollamy:

- Prostota: Jedną z największych zalet Ollamy jest jej łatwość instalacji i obsługi, nawet dla osób mniej zaawansowanych technicznie. Proces instalacji często sprowadza się do pobrania odpowiedniego pakietu dla swojego systemu operacyjnego lub wykonania pojedynczej komendy w terminalu.

- Wszechstronność: Ollama wspiera stale rosnącą bibliotekę popularnych modeli open-source. Użytkownicy mają dostęp do takich modeli jak Llama 3, Mistral, Gemma, Phi i wielu innych, co pozwala na wybór narzędzia najlepiej dopasowanego do konkretnego zadania i posiadanych zasobów sprzętowych.

- Praca Offline: Po pobraniu wybranego modelu, Ollama umożliwia korzystanie z niego bez stałego dostępu do internetu. Jest to kluczowa zaleta z punktu widzenia prywatności danych.

- Kontrola: Użytkownik ma pełną kontrolę nad tym, jakie modele i jakie ich konkretne wersje (np. różniące się liczbą parametrów, stopniem kwantyzacji) są uruchamiane. Pozwala to na precyzyjne dostosowanie działania AI do posiadanych zasobów sprzętowych i specyfiki realizowanych zadań.

Jak działa Ollama?

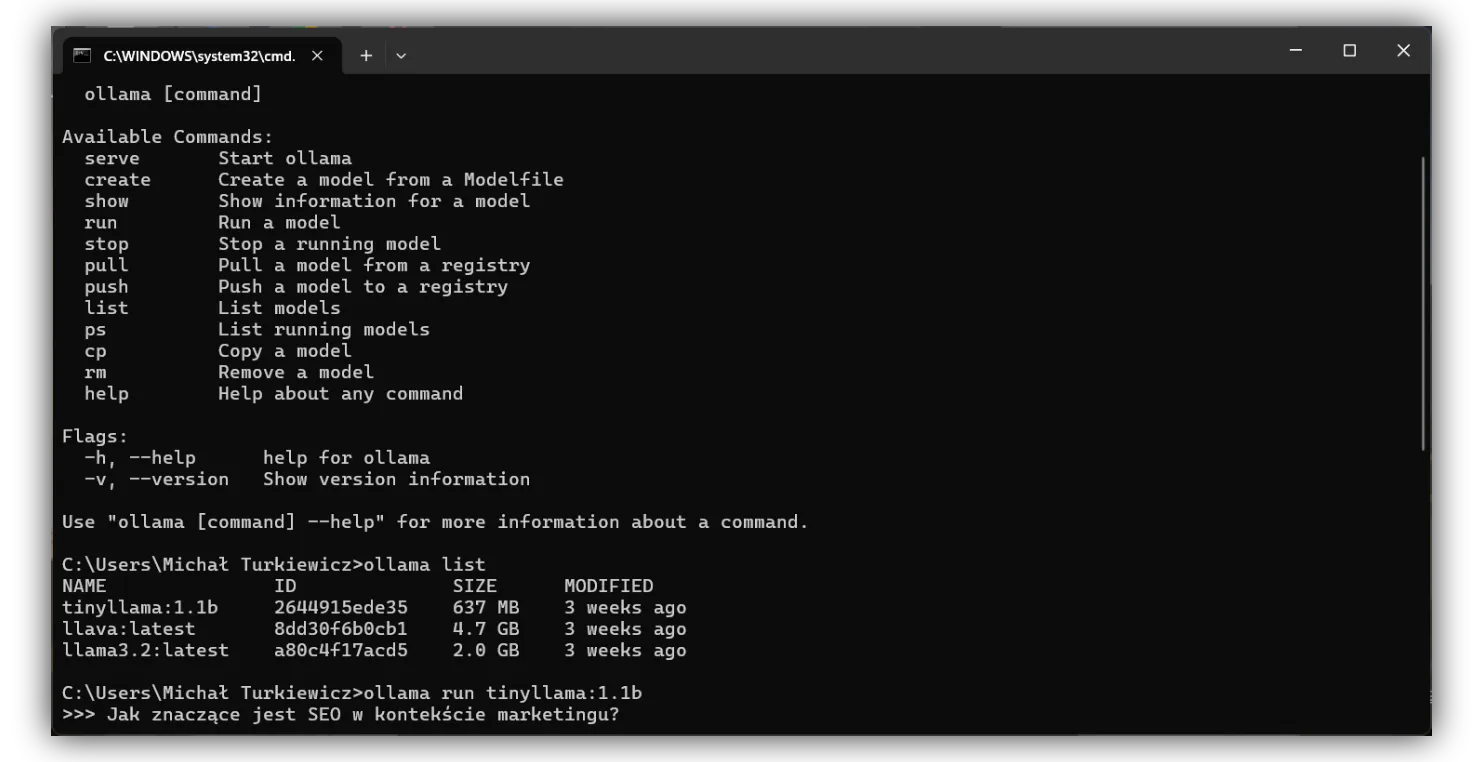

Ollama działa jako menedżer modeli i warstwa pośrednicząca, która znacząco ułatwia ich lokalne uruchomienie. Kiedy użytkownik wydaje polecenie, na przykład ollama run llama3 w terminalu, Ollama najpierw sprawdza, czy dany model jest już dostępny lokalnie. Jeśli nie, automatycznie pobiera odpowiednie pliki modelu (tzw. wagi i konfigurację) z centralnego repozytorium. Następnie Ollama konfiguruje i uruchamia lokalny serwer, który udostępnia funkcjonalność wybranego modelu poprzez API. Dzięki temu użytkownik może wchodzić w interakcję z modelem bezpośrednio z linii komend lub za pośrednictwem różnych narzędzi i aplikacji klienckich, w tym popularnych graficznych interfejsów użytkownika (GUI).

Ollamę obsługujemy poprzez wiersz poleceń

Jakie modele AI obsługuje Ollama?

Biblioteka modeli dostępnych za pośrednictwem Ollamy jest imponująca i stale rośnie. Oto kilka przykładów wraz z ich potencjalnymi zastosowaniami:

- Llama 3: Najnowsza generacja modeli od Meta, znana z doskonałych zdolności w zakresie rozumienia języka, generowania spójnego tekstu, a także kodowania. Świetnie nadaje się do tworzenia zaawansowanych chatbotów, asystentów pisania, narzędzi programistycznych i analizy danych.

- Mistral: Modele od Mistral AI, cenione za wysoką wydajność przy relatywnie niewielkich rozmiarach. Są dobrym wyborem do zadań wymagających szybkości i efektywności, takich jak systemy odpowiadania na pytania w czasie rzeczywistym czy generowanie treści na dużą skalę.

- Gemma: Rodzina otwartych modeli od Google, oferująca solidne możliwości w różnych zadaniach językowych. Mogą być wykorzystywane do badań, edukacji oraz tworzenia aplikacji opartych na AI.

- Phi-3: Mniejsze modele od Microsoftu, zoptymalizowane pod kątem wydajności na urządzeniach o ograniczonych zasobach. Idealne do eksperymentów, nauki oraz zastosowań, gdzie liczy się niski ślad pamięciowy, np. na laptopach czy nawet mocniejszych urządzeniach mobilnych.

- Modele multimodalne (np. LLaVA, Qwen-VL): Coraz częściej pojawiają się modele zdolne do przetwarzania nie tylko tekstu, ale i obrazów. Otwiera to drzwi do zastosowań takich jak opisywanie obrazów, odpowiadanie na pytania dotyczące treści wizualnych (Visual Question Answering) czy tworzenie bardziej interaktywnych aplikacji.

Potencjał tych modeli jest ogromny – od automatyzacji codziennych zadań, przez wsparcie kreatywności, analizę dużych zbiorów danych, aż po tworzenie zupełnie nowych narzędzi i usług opartych na sztucznej inteligencji.

Czy firmy mogą zyskać na wdrożeniu AI lokalnie?

Przejście na lokalne modele sztucznej inteligencji, ułatwione przez narzędzia takie jak Ollama, oferuje namacalne korzyści dla firm każdej wielkości. Te zalety obejmują bezpieczeństwo danych, efektywność kosztową czy niezależność operacyjną.

Lokalne modele AI — Ochrona Danych Wrażliwych

Jednym z najsilniejszych argumentów przemawiających za lokalnym AI jest bezpieczeństwo danych. Przetwarzanie informacji o klientach, danych finansowych, tajemnic handlowych czy innych poufnych zasobów wewnątrz własnej infrastruktury firmy eliminuje ryzyko związane z ich przesyłaniem do zewnętrznych serwerów chmurowych. W dobie rosnącej liczby cyberzagrożeń i surowych regulacji dotyczących ochrony danych, takich jak europejskie RODO (GDPR), możliwość utrzymania pełnej kontroli nad przepływem informacji jest nie do przecenienia. Lokalne LLM ułatwiają spełnienie tych wymogów, zapewniając, że wrażliwe dane nie opuszczają bezpiecznego środowiska firmy.

Potencjalna Redukcja Kosztów Operacyjnych

Choć wdrożenie lokalnego AI może wiązać się z początkową inwestycją w odpowiedni sprzęt, w dłuższej perspektywie, zwłaszcza przy dużej liczbie zapytań i intensywnym wykorzystaniu modeli, może przynieść znaczące oszczędności. Uniknięcie cyklicznych opłat za użycie API, które często są naliczane od ilości przetworzonych danych (tokenów) lub liczby zapytań, prowadzi do lepszej przewidywalności budżetu przeznaczonego na AI. Firmy, które intensywnie korzystają z AI do wewnętrznych procesów, takich jak analiza danych, generowanie raportów czy wsparcie programistów, mogą zauważyć, że całkowity koszt posiadania lokalnego rozwiązania staje się niższy niż ciągłe opłaty za usługi chmurowe.

Personalizacja i Kontrola nad Procesami

Firmy wdrażające lokalne LLM zyskują pełną kontrolę nad wykorzystywanymi modelami. Mogą je dostosowywać (poprzez proces tzw. fine-tuningu) do swoich specyficznych potrzeb, wykorzystując do tego własne, często unikalne i wrażliwe zbiory danych, bez obawy o ich wyciek czy wykorzystanie przez strony trzecie.

Szybsze Prototypowanie i Innowacje

Możliwość swobodnego eksperymentowania z różnymi modelami AI, bez barier finansowych związanych z opłatami za API i bez obaw o bezpieczeństwo danych podczas testowania nowych pomysłów, znacząco przyspiesza procesy prototypowania i wdrażania innowacji. Działy badawczo-rozwojowe (R&D) oraz zespoły produktowe mogą szybko weryfikować hipotezy, budować prototypy nowych funkcjonalności opartych na AI i iterować nad nimi znacznie szybciej, niż gdyby każde zapytanie testowe generowało dodatkowe koszty. To z kolei może wyrównać szanse dla mniejszych firm i startupów w konkurowaniu z korporacjami dysponującymi dużymi budżetami na AI.

AI w Chmurze — Nadal Istotne, ale czy dla każdego?

Pomimo rosnącej popularności lokalnych rozwiązań LLM, sztuczna inteligencja w chmurze wciąż odgrywa kluczową rolę i dla wielu zastosowań pozostaje optymalnym wyborem. Ważne jest, aby zrozumieć jej mocne strony oraz ograniczenia, szczególnie w kontekście pojawienia się narzędzi takich jak Ollama.

Na rynku dostępnych jest wiele zaawansowanych rozwiązań chmurowych, które zyskały uznanie zarówno wśród indywidualnych użytkowników, jak i małych oraz dużych przedsiębiorstw. Do najpopularniejszych należą API oferowane przez OpenAI, dające dostęp do rodziny modeli GPT (w tym ChatGPT), API od Anthropic z ich modelem Claude, oraz API od Google, udostępniające wszechstronne modele Gemini, zdolne do przetwarzania informacji multimodalnych. Te platformy zdefiniowały obecne postrzeganie możliwości AI i nadal wyznaczają kierunki rozwoju.

Główne zalety chmury są trudne do przecenienia.

Przede wszystkim, dostawcy usług chmurowych często jako pierwsi udostępniają publicznie swoje najnowsze, najbardziej zaawansowane i nierzadko największe modele językowe. Dla firm i deweloperów pragnących korzystać z absolutnej czołówki technologicznej chmura jest naturalnym wyborem. Kolejnym atutem jest olbrzymia skalowalność. Infrastruktura chmurowa pozwala na elastyczne dostosowywanie zasobów do bieżących potrzeb, obsługując zarówno małe projekty, jak i aplikacje o globalnym zasięgu z milionami użytkowników.

Jednakże, w kontekście rosnących możliwości lokalnych LLM, pewne wady rozwiązań chmurowych stają się bardziej widoczne. Cykliczne koszty, oparte na subskrypcjach lub modelu pay-as-you-go, mogą kumulować się do znacznych kwot, szczególnie przy intensywnym wykorzystaniu. Kwestie prywatności danych są kolejnym istotnym problemem; powierzanie wrażliwych informacji zewnętrznym dostawcom zawsze wiąże się z pewnym ryzykiem, pomimo stosowanych zabezpieczeń. Potencjalny „vendor lock-in” oznacza uzależnienie od technologii, polityki cenowej i warunków świadczenia usług jednego dostawcy, co może ograniczać elastyczność i siłę negocjacyjną w przyszłości. Działanie systemów AI w chmurze jest również nierozerwalnie związane z dostępem do stabilnego połączenia internetowego oraz podatne na zmiany w polityce dostawcy, takie jak modyfikacje API czy nawet wycofanie niektórych modeli lub funkcjonalności. Warto też zauważyć, że dostęp do najnowszych modeli w chmurze, choć kuszący, może być mieczem obosiecznym. Często wiąże się z najwyższymi kosztami i większą skłonnością do generowania nieprecyzyjnych odpowiedzi (tzw. „halucynacji”) w przypadku modeli będących jeszcze w fazie eksperymentalnej.

Ollama a przyszłość AI: Nowy złoty środek

Pojawienie się narzędzi takich jak Ollama nie oznacza natychmiastowego końca dominacji AI w chmurze. Zamiast tego, jesteśmy świadkami kształtowania się nowego, bardziej zrównoważonego ekosystemu sztucznej inteligencji, w którym lokalne LLM odgrywają coraz ważniejszą rolę, zmieniając dynamikę sił i otwierając nowe perspektywy.

Kluczowym aspektem wpływu Ollamy i podobnych narzędzi jest demokratyzacja dostępu do potężnych technologii AI. Upraszczając proces instalacji, konfiguracji i uruchamiania zaawansowanych modeli językowych na osobistych komputerach, Ollama sprawia, że technologia ta staje się dostępna nie tylko dla wielkich korporacji dysponujących ogromnymi budżetami i zespołami specjalistów, ale także dla mniejszych firm, indywidualnych deweloperów, badaczy i hobbystów. To fundamentalna zmiana, która poszerza grono twórców i użytkowników AI, potencjalnie prowadząc do fali nowych innowacji.

Lokalne LLM, wspierane przez narzędzia takie jak Ollama, stają się ważną alternatywą i uzupełnieniem dla dominujących rozwiązań chmurowych. Szczególnie tam, gdzie priorytetem jest ochrona prywatności danych, potrzeba pełnej kontroli nad procesami przetwarzania informacji oraz optymalizacja kosztów.

Wizja przyszłości coraz wyraźniej rysuje się jako model hybrydowy. W takim modelu firmy i użytkownicy będą świadomie wybierać między rozwiązaniami lokalnymi a chmurowymi – lub strategicznie łączyć oba podejścia – w zależności od konkretnego zadania, wymagań technicznych, dostępnego budżetu czy potrzeby skalowalności.

Jak Zacząć Swoją Przygodę z Ollama? – Instalacja i konfiguracja

Rozpoczęcie pracy z Ollamą i lokalnymi modelami LLM jest zaskakująco proste i nie wymaga zaawansowanej wiedzy:

- Pobierz Ollamę:

Pierwszym krokiem jest pobranie instalatora Ollamy z jej oficjalnej strony internetowej. - Zainstaluj swój pierwszy model:

Po zainstalowaniu Ollamy, uruchomienie pierwszego modelu jest niezwykle proste. Otwórz terminal i wpisz komendę, aby pobrać i uruchomić popularny model, na przykład Llama 3 w wersji 8 miliardów parametrów:

ollama run llama3Ollama automatycznie pobierze niezbędne pliki modelu (jeśli nie ma ich jeszcze na Twoim komputerze), co może zająć chwilę w zależności od rozmiaru modelu i prędkości Twojego internetu. Po pobraniu model zostanie załadowany i będziesz mógł od razu zacząć z nim interakcję bezpośrednio w terminalu, zadając pytania lub wydając polecenia.

- Eksploruj i eksperymentuj:

Oficjalna strona Ollamy jest najlepszym źródłem informacji o dostępnych modelach, ich rozmiarach, wymaganiach i potencjalnych zastosowaniach. Znajdziesz tam również szczegółową dokumentację i linki do społeczności, gdzie możesz uzyskać wsparcie i podzielić się swoimi doświadczeniami.

Podsumowanie

Ollama i podobne rozwiązania nie tyle zwiastują „koniec dominacji AI w chmurze”, ile raczej zapowiadają nowy, bardziej zrównoważony balans mocy. Otwierają one nowe horyzonty zarówno dla użytkowników indywidualnych – programistów, badaczy, twórców czy po prostu pasjonatów technologii – jak i dla firm, zwłaszcza tych małych i średnich.

To nie jest wybór „albo-albo” między chmurą a lokalnym AI. To raczej ewolucja w kierunku bardziej zróżnicowanego, otwartego ekosystemu, gdzie użytkownicy i organizacje będą mogli świadomie dobierać narzędzia najlepiej odpowiadające ich specyficznym potrzebom, wymaganiom bezpieczeństwa i możliwościom budżetowym, często decydując się na rozwiązania hybrydowe.